- Autors Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:50.

- Pēdējoreiz modificēts 2025-01-22 17:33.

Nespeciālisti izsakoties, sevi - uzmanību mehānisms ļauj ieejām mijiedarboties savā starpā (“ sevi ”) un uzziniet, kam viņiem būtu jāmaksā vairāk uzmanību uz (“ uzmanību ”). Izvadi ir šo mijiedarbību kopumi un uzmanību punktu skaitu.

Turklāt, kas ir pašapvēršanās?

Pats - uzmanību , ko dažreiz sauc par iekšējo uzmanību ir uzmanību mehānisms, kas attiecas uz vienas secības dažādām pozīcijām, lai aprēķinātu secības attēlojumu.

Kā arī, kas ir sevis uzmanība dziļā mācībā? Vispirms definēsim, kas sevi - Uzmanību ” ir. Cheng et al savā rakstā ar nosaukumu “Ilgtermiņa īstermiņa atmiņas tīkli Mašīna Lasīšana”, definēts sevi - Uzmanību kā vienas secības vai teikuma dažādu pozīciju saistīšanas mehānisms, lai iegūtu spilgtāku attēlojumu.

Kas šajā sakarā ir uzmanības mehānisms?

Uzmanības mehānisms ļauj dekodētājam aplūkot dažādas avota teikuma daļas katrā izvades ģenerēšanas posmā. Tā vietā, lai iekodētu ievades secību vienā fiksētā konteksta vektorā, mēs ļaujam modelim iemācīties ģenerēt konteksta vektoru katram izvades laika posmam.

Kas ir uz uzmanību balstīts modelis?

Uzmanību - balstīti modeļi pieder pie klases modeļiem ko parasti sauc par secību uz secību modeļiem . Šo mērķis modeļiem , kā norāda nosaukums, tas rada izvades secību, ņemot vērā ievades secību, kas parasti ir dažāda garuma.

Ieteicams:

Kā darbojas Spring AOP starpniekserveris?

AOP starpniekserveris: objekts, kas izveidots ar AOP ietvaru, lai īstenotu aspektu līgumus (konsultētu metodes izpildi un tā tālāk). Pavasara ietvarā AOP starpniekserveris būs JDK dinamiskais starpniekserveris vai CGLIB starpniekserveris. Aušana: aspektu saistīšana ar citiem lietojumprogrammu veidiem vai objektiem, lai izveidotu ieteicamu objektu

Kā darbojas spoguļtelevizors?

Spoguļtelevizors sastāv no speciāla daļēji caurspīdīga spoguļstikla ar LCD televizoru aiz spoguļa virsmas. Spogulis ir rūpīgi polarizēts, lai ļautu attēlam pārsūtīt caur spoguli, tādējādi, kad televizors ir izslēgts, ierīce izskatās kā spogulis

Vai Amazon Fire Stick darbojas ar Google sākumlapu?

Jā, bet ne sākotnēji. Lai gan abas ierīces sākotnēji nedarbojas kopā, varat izmantot risinājumu, lai Fire Stick un Google Home sadarbotos kopā

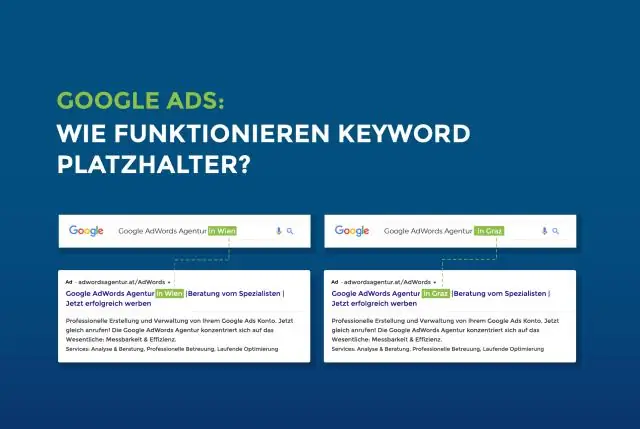

Kā darbojas vietturis?

Viettura atribūts norāda īsu mājienu, kas apraksta ievades lauka paredzamo vērtību (piemēram, parauga vērtība vai īss paredzamā formāta apraksts). Piezīme. Viettura atribūts darbojas ar šādiem ievades veidiem: teksts, meklēšana, url, tel, e-pasts un parole

Kas ir sevis __ klase __ Python?

Sevi. _class_ ir atsauce uz pašreizējās instances veidu. Abstract1 gadījumos tā būtu pati abstract1 klase, kas ir tas, ko jūs nevēlaties ar abstraktu klasi