- Autors Lynn Donovan [email protected].

- Public 2023-12-15 23:50.

- Pēdējoreiz modificēts 2025-01-22 17:33.

1) Neliela faila problēma iekšā HDFS : Uzglabā daudz mazi faili kas ir ārkārtīgi mazāks nekā bloka izmēru nevar efektīvi apstrādāt HDFS . Lasot cauri mazi faili ietver daudzus meklējumus un lielu lēcienu starp datu mezglu uz datu mezglu, kas ir neefektīva datu apstrāde.

Papildus tam, kuri faili nodarbojas ar nelielām failu problēmām programmā Hadoop?

1) HAR ( Hadoop Arhīvs) Faili ir iepazīstināts ar risināt mazo failu problēmu . HAR ir ieviesis slāni virsū HDFS , kas nodrošina saskarni failu piekļūstot. Izmantojot Hadoop arhīva komanda, HAR failus tiek izveidoti, kas darbojas a MapReduce darbs iepakot failus tiek arhivēts mazāks skaits HDFS faili.

Turklāt, vai HDFS var izmantot dažādus bloku izmērus vairākiem failiem? Noklusējums Izmērs no bloķēt ir 64 MB. tu var mainiet to atkarībā no jūsu prasībām. Nākot uz jūsu jautājumu, jā, jūs var izveidot vairākus failus mainot bloku izmēri bet reāllaikā šis gribu nedod priekšroku ražošanai.

Turklāt, kāpēc HDFS optimāli neapstrādā mazus failus?

Problēmas ar mazi faili un HDFS Katrs failu , direktoriju un bloķēt HDFS ir tiek attēlots kā objekts namenode atmiņā, katrs no tiem aizņem 150 baitus, kā īkšķis. Turklāt HDFS nav pielāgota efektīvai piekļuvei mazi faili : tas ir galvenokārt paredzēts liela izmēra straumēšanas piekļuvei failus.

Kāpēc Hadoop darbojas lēni?

Lēns Apstrādes ātrums Šis disks meklē aizņem laiku, tādējādi padarot visu procesu ļoti lēns . Ja Hadoop apstrādā datus nelielā apjomā, tas ir ļoti lēns salīdzinoši. Tas ir ideāli piemērots lielām datu kopām. Kā Hadoop pamatā ir pakešu apstrādes dzinējs, tā ātrums reāllaika apstrādei ir mazāks.

Ieteicams:

Vai mp4 failiem ir EXIF dati?

2 atbildes. Jā, bet tas atšķiras atkarībā no faila formāta. Piemēram, QuickTime konteinera formātā ir daudz veidu metadati. Šo formāta veidu izmanto MOV, M4V, MP4 un citi mazāk populāri

Kāda ir atšķirība starp programmu failiem un programmu failiem 86x?

Parastajā mapē Programmas faili ir 64 bitu lietojumprogrammas, savukārt 32 bitu lietojumprogrammām tiek izmantota programma Programmu faili (x86). Instalējot 32 bitu lietojumprogrammu personālajā datorā ar 64 bitu Windows, automātiski tiek novirzīts uz Programmu faili (x86). Skatiet programmu Faili un x86

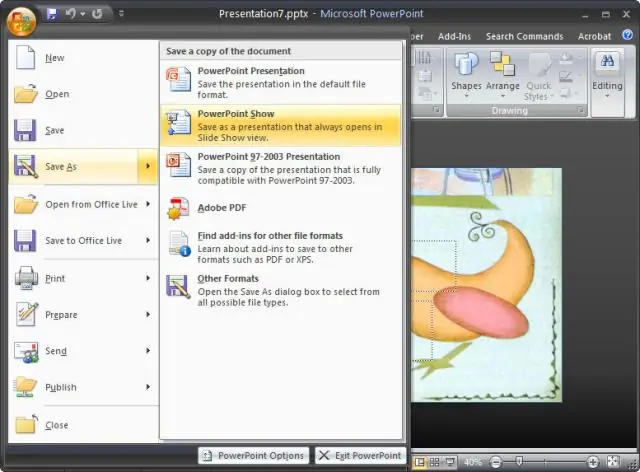

Kāda ir atšķirība starp PowerPoint PPT PPTX un PPS Ppsx failiem?

Atšķirība ir tajā, kā PowerPoint tos apstrādā: pēc noklusējuma PPT un PPTX faili programmā PowerPoint tiek atvērti rediģēšanas režīmā, ļaujot izmantot visas izvēlnes un komandas. Pēc noklusējuma PPS un PPSX faili tiek atvērti slaidrādes (atskaņošanas-prezentācijas) režīmā, un jūs neredzat PowerPoint saskarni

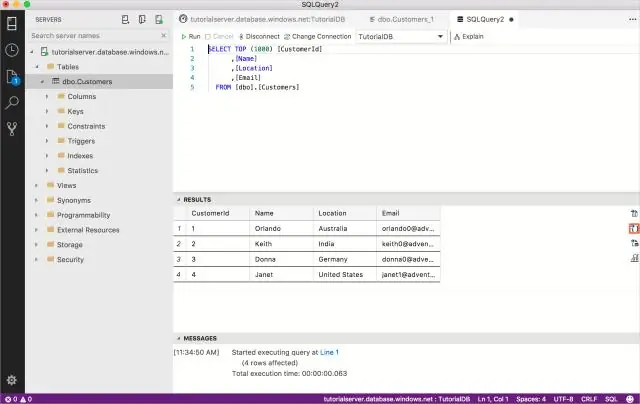

Kā izdzēst SQL Server mapi no programmas failiem?

Izvēlnē Sākt atlasiet “Dators”, lai palaistu sākotnējo Windows 7 failu pārvaldnieku. Atlasiet sistēmas disku, piemēram, "C:". Atveriet mapi "Programmu faili", pēc tam atrodiet un atlasiet mapi "Microsoft SQL Server". Nospiediet “Dzēst” un atlasiet “Jā”, kad tiek prasīts apstiprināt dzēšanu

Kā jūs rīkojaties ar zip failiem?

Zip un unzip failus Atrodiet failu vai mapi, kuru vēlaties saspiest. Nospiediet un turiet (vai ar peles labo pogu noklikšķiniet) uz faila vai mapes, atlasiet (vai norādiet uz) Sūtīt uz un pēc tam atlasiet Saspiestā (zip) mape. Tajā pašā vietā tiek izveidota jauna zip mape ar tādu pašu nosaukumu